Concurrent Container

Vector、Hashtable

Vector 特点

类似一个线程安全的 ArrayList

1* 大量容器操作方法都采用同步方法

1 Vector<String> vector = new Vector<>();

2 vector.add("test");

3 System.out.println(vector.get(0));

Hashtable 特点

类似一个线程安全的 HashMap

1* 大量容器操作方法都采用同步方法

1 Hashtable<String, String> hashtable = new Hashtable<>();

2 hashtable.put("a", "80%");

3 System.out.println(hashtable.get("a"));

Collections.synchronizedXXX()

虽然这两个类不是线程安全的,但是可以用 Collections.synchronizedList(new ArrayList<Integer>())、Conllections.synchronizedMap(new HashMap<>()) 让其变成线程安全的。

1* 大量使用同步代码块,并没有性能提升

1// ArrayList 升级

2List<Integer> list = Collections.synchronizedList(new ArrayList<Integer>());

3// HashMap 升级

4Map<Object, Object> objectObjectMap = Collections.synchronizedMap(new HashMap<>());

ConcurrentHashMap、CopyOnWriteArrayList

取代同步的 HashMap 和同步的 ArrayList。

绝大多数并发情况下,CocurrentHashMap、CopyOnWriteArrayList 的性能都更好。

Java Map Hierarchy

Map 体系下的所有集合类型都要求传入的** key 必须为不可变对象**,即对象的 hash 值不会改变。

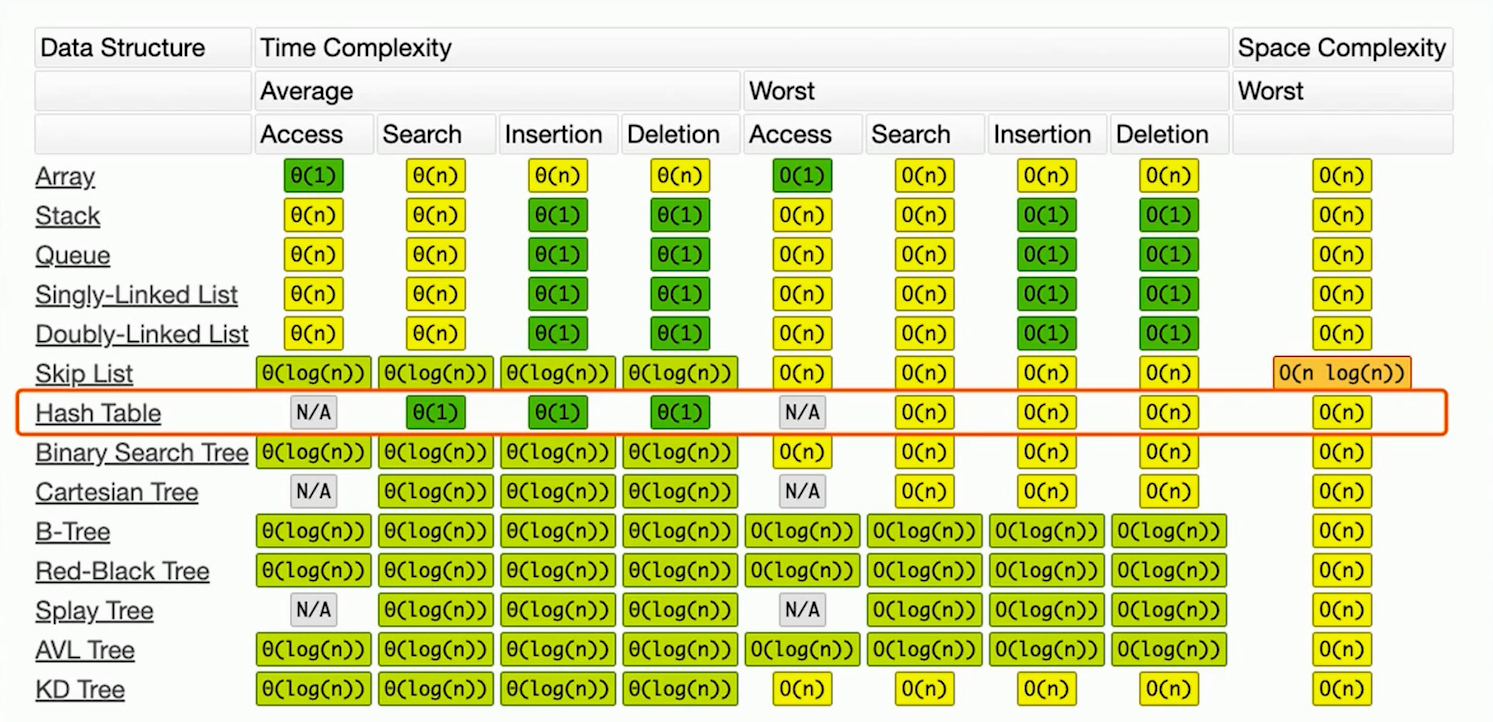

Time Complexity

Map(Interface)

HashMap

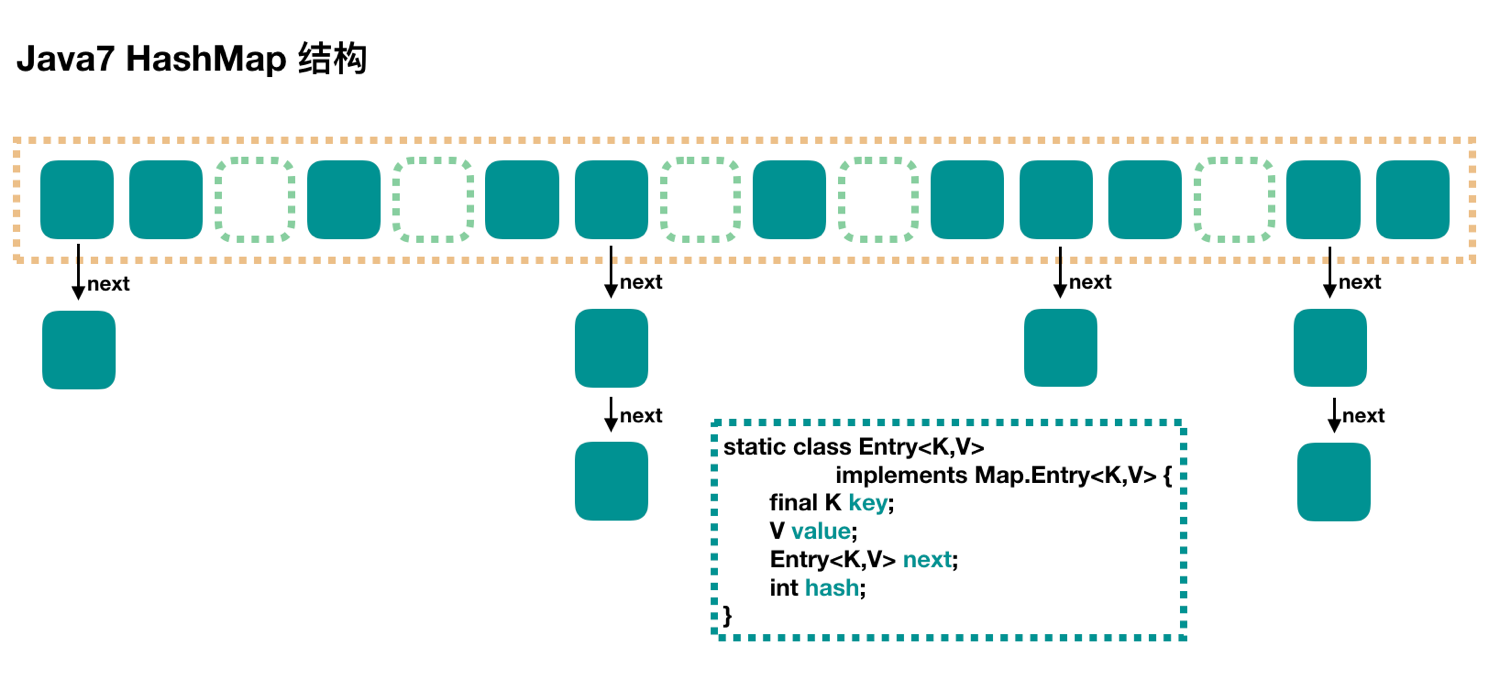

当我们给 put 方法传递键和值时,会对键调用 hashCode()方法,返回的 hashCode 用于找到 bucket 位置来存储键对象和值对象,作为 Map.Entry.

1* 允许 key 为 null

2* 线程不安全

3* 迭代时不允许修改内容

4* 只读的并发是安全的

为什么 HashMap 是线程不安全的?

1* 同时 put 碰撞(hash)导致数据丢失

2* 同时 put 扩容导致数据丢失

3* 死循环造成的 CPU 100%(多个线程同时扩容,会造成链表的自循环,A指向B,B指向A。 HashMap本身就不支持并发,所以也不是个问题)

JDK 1.7 采用拉链法

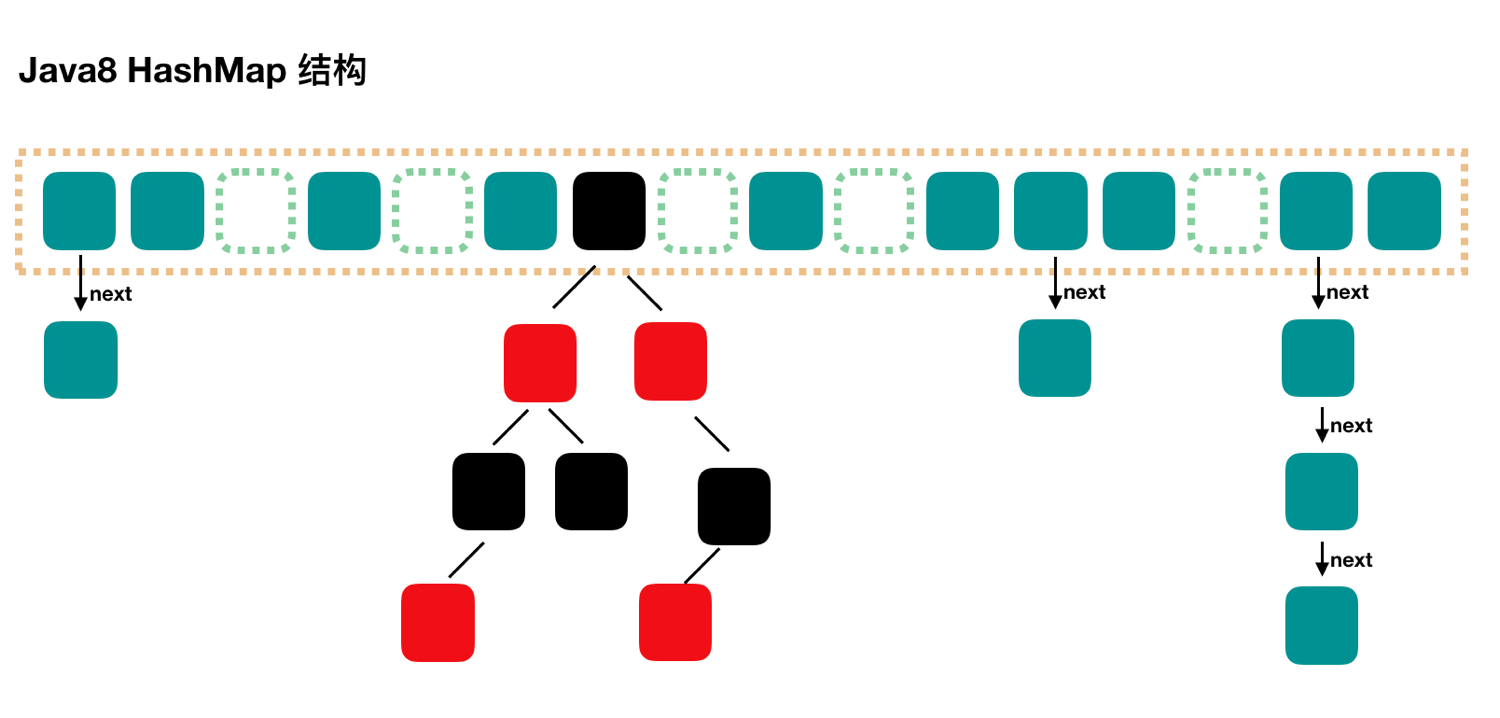

JDK 1.8 引入数组 + 链表 + 红黑树

数组的加入提高了并发性,红黑树的加入使得查找的时间复杂度从 O(N) 变为 O(logN)。

红黑树优点

1* 对二叉查找树 BST 的一种平衡策略,** O(logN)** vs O(N)

2* 会自动平衡,防止极端不平衡从而影响查找效率的情况发生

红黑树特点

1* 每个节点要么是红色,要么是黑色,但根节点永远是黑色

2* 红色节点不能连续(也即是,红色节点的孩子和父亲都不能是红色)

3* 从任一节点到其子树中每个叶子节点的路径都包含相同数量的黑色节点

4* 所有的叶子节点都是黑色的

Hashtable

1* 不允许 key 为 null

2* 采用大量 synchonrized 同步方法对集合进行操作,性能较差。

3* 线程安全

LinkedHashMap

1* 保留插入元素的顺序

TreeMap

1* 由于实现 SortedMap 接口,默认会对元素进行排序。

ConcurrentHashMap

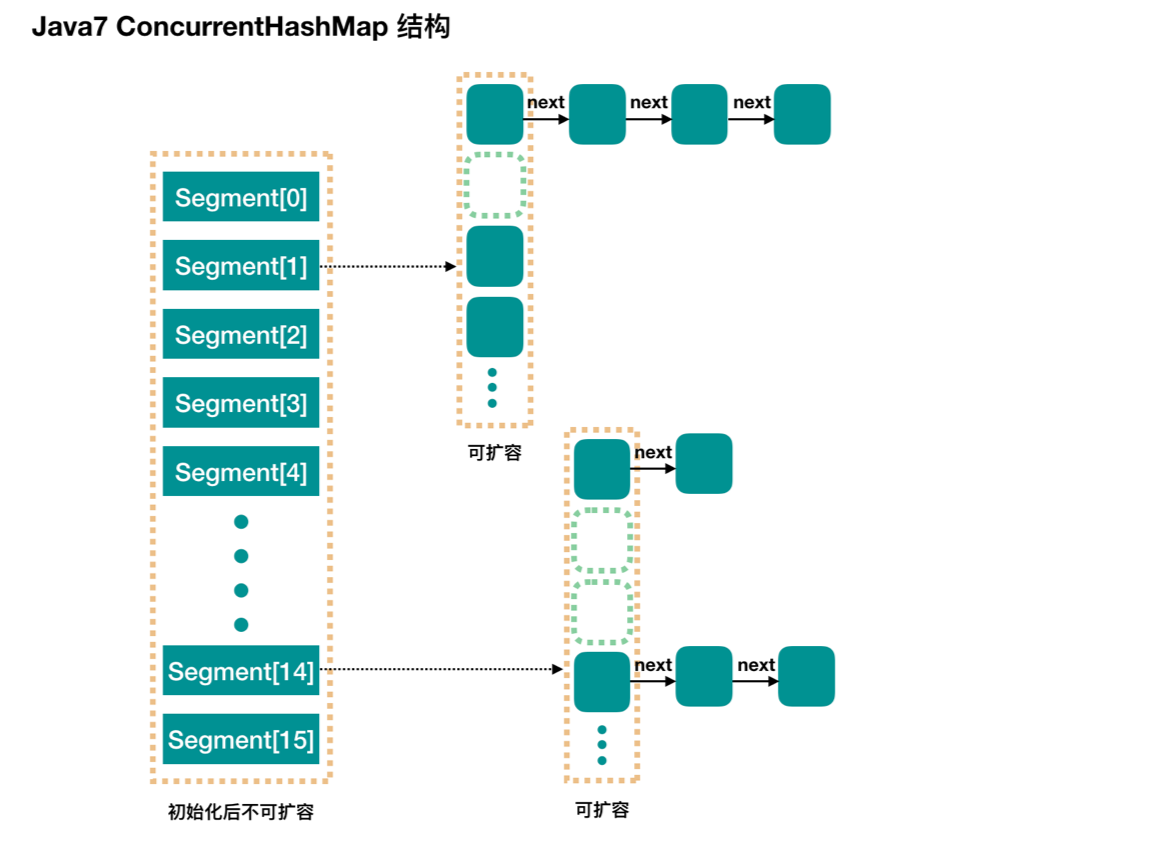

JDK 1.7 的实现

Java 7 中的 ConcurrentHashMap 最外层是多个 segment,每个 segment 的底层数据结构与 HashMap 类似,仍然是数组和链表组成的拉链法。

每个 segment 独立上 ReentrantLock 锁,每个 segment 之间互不影响,提高了并发效率。segment 类继承 ReentrantLock 来保证线程安全。

ConcurrentHashMap 默认有 16 个 segment,所以最多可以同时支持 16 个线程并发写(操作分别分布在不同的 Segment 上)。这个默认值可以在初始化的时候设置为其他值,但是一旦初始化以后,是不可以扩容的。

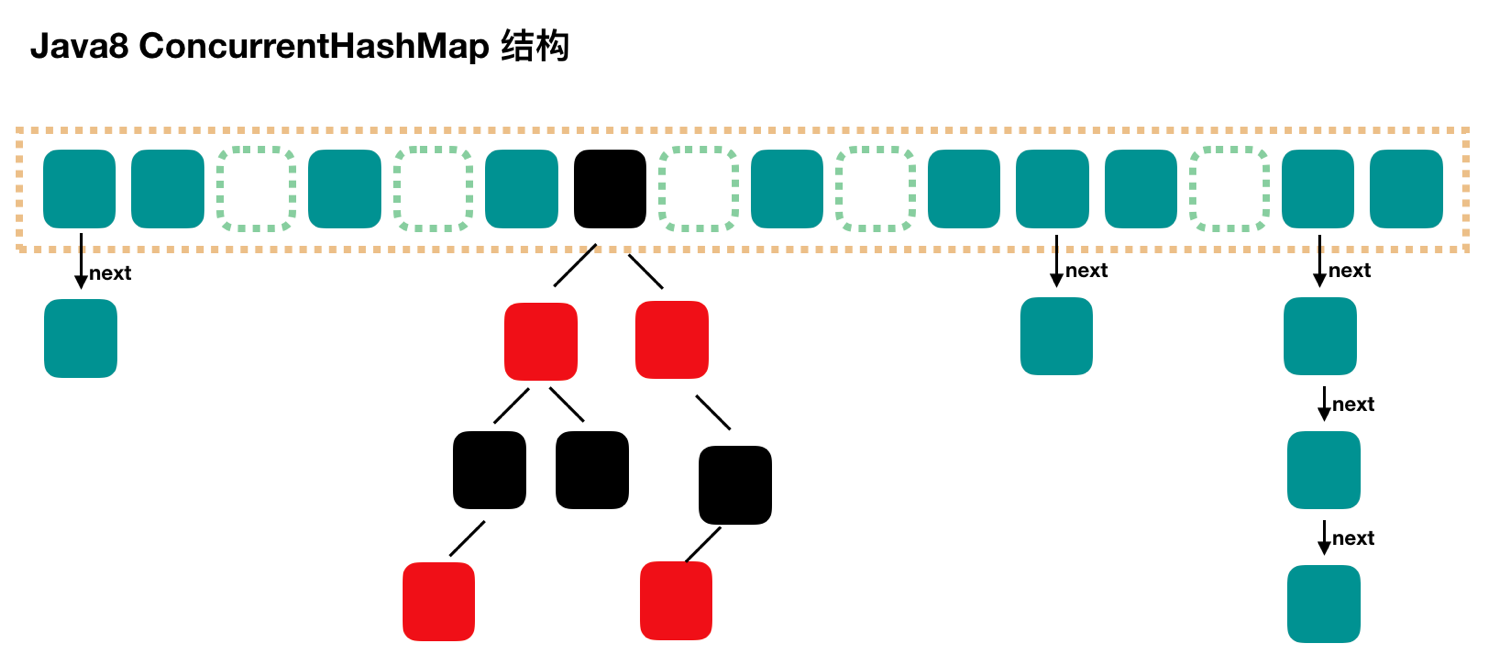

JDK 1.8 引入 CAS + synchonrized

ConcurrnetHashMap 在 JDK 1.8 中完全借鉴了 JDK1.8 中的 HashMap 的实现。

取消了 segment 分段锁,引入 Node数组 提高了并发性(锁粒度更细)的同时也减少了并发冲突几率,链表 触发 红黑树 的加入使得查找的时间复杂度从 O(N) 变为 O(logN)。

保证并发安全性:CAS(读) + synchronized(写)

1# putValue 流程

21. 判断 key value 不为空

32. 计算 hash 值

43. 根据对应位置节点的类型,来赋值,(helpTransger | 增长链表 | 给红黑树增加节点)

54. 检查满足阈值(8)并且数组大于阈值(64)就 “红黑树化”,如果数组阈值小于64,则优先扩容数组。

65. 返回oldValue

7

8# get 流程

91. 计算 hash 值

102. 找到对应的位置,根据情况进行:

113. 直接取值

124. 红黑树里找值

135. 遍历链表取值

146. 返回找到的结果

为什么超过 8 要转为红黑树?

正常情况下几乎不会碰到树化的情况,概率只有千万分之一,正常情况下链表的长度不会达到 8。(如果真的达到 8 说明 hash 算法出了问题,为了保证在这种极端情况下让链表查询依然有效率,在这种情况下就会触发 “树化”)。

作者进行了 泊松分布概率函数 的计算如下:

1 * 0: 0.60653066

2 * 1: 0.30326533

3 * 2: 0.07581633

4 * 3: 0.01263606

5 * 4: 0.00157952

6 * 5: 0.00015795

7 * 6: 0.00001316

8 * 7: 0.00000094

9 * 8: 0.00000006

10 * more: less than 1 in ten million

ConcurrentHashMap 负载因子为什么是 0.75 ?

这样的默认值其实就是时间和空间成本上的一种折中:

在 ConcurrentHashMap 中的注释中提到:一个节点在 Bucket 中出现的概率是符合泊松分布的,使用 0.75 为负载因子,可以降低节点在某一个特定桶中出现的概率,降低了 hash 冲突,也就降低了查询时间(而查询是最频繁的操作(HashMap 的 get()与 put()方法都要用到查询)),同时也不会因为负载因子过小而导致 hash 表过大,占用过多的内存空间。

1* 负载因子越小,降低 hash 冲突,提高查询效率,增加内存占用率

2* 负载因子越大,提升 hash 冲突,降低查询效率,减少内存占用率

HashMap 中定义了几个常量

1static final int DEFAULT_INITIAL_CAPACITY = 1 << 4; // aka 16

2static final int MAXIMUM_CAPACITY = 1 << 30;

3static final float DEFAULT_LOAD_FACTOR = 0.75f;

4static final int TREEIFY_THRESHOLD = 8;

5static final int UNTREEIFY_THRESHOLD = 6;

6static final int MIN_TREEIFY_CAPACITY = 64;

7

8`DEFAULT_INITIAL_CAPACITY`: 初始容量,也就是默认会创建 16 个箱子,箱子的个数不能太多或太少。如果太少,很容易触发扩容,如果太多,遍历哈希表会比较慢。

9`MAXIMUM_CAPACITY`: 哈希表最大容量,一般情况下只要内存够用,哈希表不会出现问题。

10`DEFAULT_LOAD_FACTOR`: 默认的负载因子。因此初始情况下,当键值对的数量大于 `16 * 0.75 = 12` 时,就会触发扩容。

11`TREEIFY_THRESHOLD`: 上文说过,如果哈希函数不合理,即使扩容也无法减少箱子中链表的长度,因此 Java 的处理方案是当链表太长时,转换成红黑树。这个值表示当某个箱子中,链表长度大于 8 时,有可能会转化成树。

12`UNTREEIFY_THRESHOLD`: 在哈希表扩容时,如果发现链表长度小于 6,则会由树重新退化为链表。

13`MIN_TREEIFY_CAPACITY`: 在转变成树之前,还会有一次判断,只有键值对数量大于 64 才会发生转换。这是为了避免在哈希表建立初期,多个键值对恰好被放入了同一个链表中而导致不必要的树化。

错误的使用 ConcurrentHashMap 也会导致线程不安全

一个工具类本身是线程安全的,但并不意味着多个组合使用工具类的操作也是线程安全的,不恰当的使用工具类,也会带来线程安全的问题。

repalce:组合操作

1import java.util.concurrent.ConcurrentHashMap;

2

3/**

4 * 描述: 组合操作并不保证线程安全

5 */

6public class OptionsNotSafe implements Runnable {

7

8 private static ConcurrentHashMap<String, Integer> scores = new ConcurrentHashMap<String, Integer>();

9

10 public static void main(String[] args) throws InterruptedException {

11 scores.put("小明", 0);

12 Thread t1 = new Thread(new OptionsNotSafe());

13 Thread t2 = new Thread(new OptionsNotSafe());

14 t1.start();

15 t2.start();

16 t1.join();

17 t2.join();

18 System.out.println(scores);

19 }

20

21 @Override

22 public void run() {

23 for (int i = 0; i < 1000; i++) {

24 while (true) {

25 Integer score = scores.get("小明");

26 Integer newScore = score + 1;

27

28 //false:代表值已经被其他线程修改过

29 //true:代表本线程修改成功

30 //repalce() 方法是一个组合操作, 检查预期值是否为 score ,如果是则尝试替换成 newscore,否则重新进入while()循环获取最新的 score

31 boolean b = scores.replace("小明", score, newScore);

32

33 //成功修改的时候退出

34 if (b) {

35 break;

36 }

37 }

38 }

39

40 }

41}

putIfAbsent:组合操作(等价于如下代码)

1// 存在就取出,不存在就put进去。

2 if(!map.containsKey(key))

3 return map.put(key,value)'

4 else

5 return map.get(key);

CopyOnWirteArrayList

代替 Vector 和 synchronizedList 的高性能并发版的 ArrayList。

1* Vector 和 synchronizedList 锁的粒度大,大量使用同步方法导致并发性能较差。

2* 迭代的时候无法编辑,导致用法和功能都不够强大

Copy-On-Wirte 并发容器还包括 CopyOnWriteArraySet,用来替代同步 Set。

CopyOnWirteArrayList 适用场景

1* 读多,写少 :黑名单、每日更新;监听器:迭代操作远多于修改操作。

2* 读操作可以尽可能的快,而写即使慢一些也没有太大关系

CopyOnWirteArrayList 读写规则

1* 读写锁的规则升级:读取时完全不用加锁的,并且写入也不会阻塞读取操作。只有写入和写入之间需要进行同步等待。

2* 也就是说,只有写入和写入之间才会有锁。

示例:CopyOnWriteArrayList 可以在迭代的过程中修改数组内容,但是 ArrayList 不行。

1import java.util.ArrayList;

2import java.util.Iterator;

3import java.util.concurrent.CopyOnWriteArrayList;

4

5/**

6 * 描述:演示CopyOnWriteArrayList可以在迭代的过程中修改数组内容,但是ArrayList不行,对比

7 */

8public class CopyOnWriteArrayListDemo1 {

9

10 public static void main(String[] args) {

11// ArrayList<String> list = new ArrayList<>();

12 CopyOnWriteArrayList<String> list = new CopyOnWriteArrayList<>();

13

14 list.add("1");

15 list.add("2");

16 list.add("3");

17 list.add("4");

18 list.add("5");

19

20 Iterator<String> iterator = list.iterator();

21

22 while (iterator.hasNext()) {

23 System.out.println("list is" + list);

24 String next = iterator.next();

25 System.out.println(next);

26

27 if (next.equals("2")) {

28 list.remove("5");

29 }

30 if (next.equals("3")) {

31 list.add("3 found");

32 }

33 }

34 }

35}

1list is[1, 2, 3, 4, 5]

21

3list is[1, 2, 3, 4, 5]

42

5list is[1, 2, 3, 4]

63

7list is[1, 2, 3, 4, 3 found]

84

9list is[1, 2, 3, 4, 3 found]

105

CopyOnWirteArrayList 实现原理

当发生写时,复制副本,基于副本操作,容器引用指向新的副本。

这样读就可以不受限制,读可以继续在原始容器中读,写在副本中进行,可以同时进行。虽然会有一定程度上的过期,但是提高了并发效率。

适用于更新频率很低的情况,在这样的情况下不必担心会读取到过期数据的问题,因为本身对数据的实时性要求就不是特别高。

创建新副本,读写分离的思想。

“不可变”原理:旧的容器没有人去修改,所以旧的容器是不可变的,既然不会变,完全就是线程安全的,完全可以并发的读。

迭代的时候:读取依然使用旧的容器,所以不会报错。

CopyOnWirteArrayList 的缺点

1* CopyOnWirte 容器只能保证数据的最终一致性,不能保证数据的实时一致性。所以如果你希望写入的数据,马上可以读到,请不要使用 CopyOnWrite 容器。

2* 内存占用问题: 因为 CopyOnWrite 的写是复制机制,所以在进行写操作的时候,内存里会同时驻扎两个对象的内存。

1import java.util.Iterator;

2import java.util.concurrent.CopyOnWriteArrayList;

3

4/**

5 * 描述: 对比两个迭代器

6 */

7public class CopyOnWriteArrayListDemo2 {

8

9 public static void main(String[] args) throws InterruptedException {

10 CopyOnWriteArrayList<Integer> list = new CopyOnWriteArrayList<>(new Integer[]{1, 2, 3});

11

12 System.out.println(list);

13

14 Iterator<Integer> itr1 = list.iterator();

15

16 list.remove(2);

17 Thread.sleep(1000);

18 System.out.println(list);

19

20 Iterator<Integer> itr2 = list.iterator();

21

22 itr1.forEachRemaining(System.out::println);// 1 2 3 取决于诞生时间

23 itr2.forEachRemaining(System.out::println);// 1 2 取决于诞生时间

24

25 }

26}

1[1, 2, 3]

2[1, 2]

31

42

53

61

72

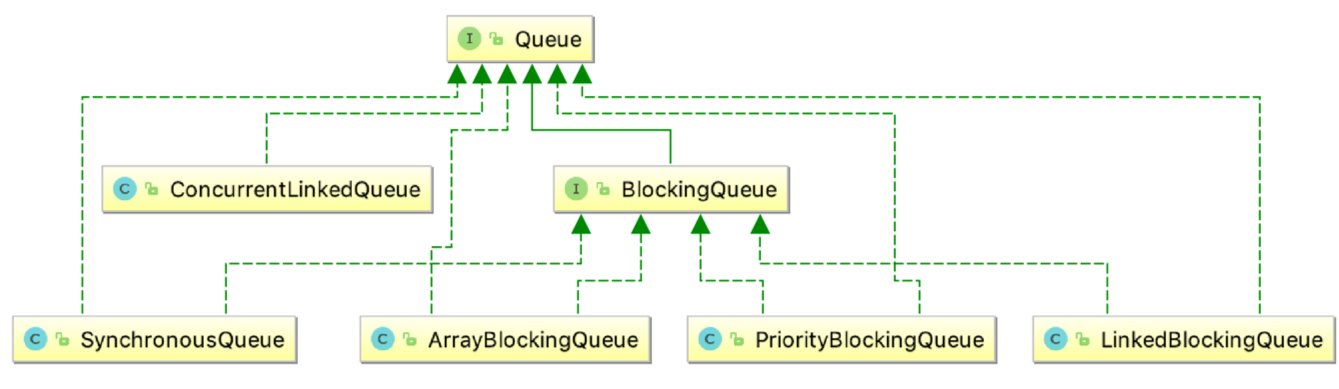

Concurrent Queue

各并发队列关系图

为什么要使用队列?

1* 使用队列可以在线程间传递数据:生产者消费者模式、银行转账

2* 考虑锁等线程安全问题的重任从 “你” 转移到了 “队列” 上。(变为阻塞队列的使用者)

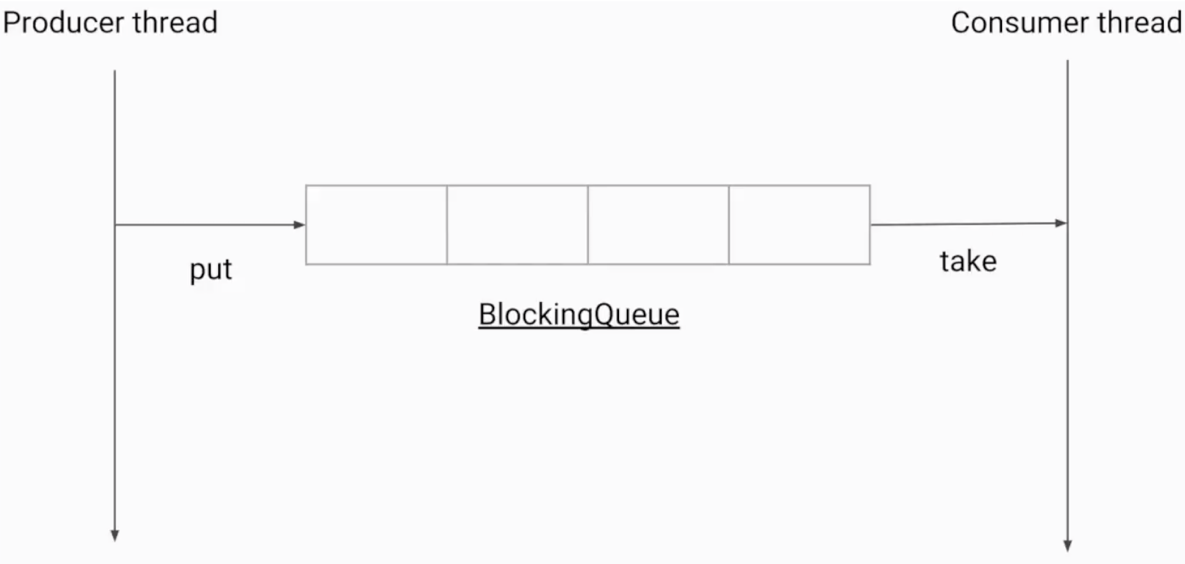

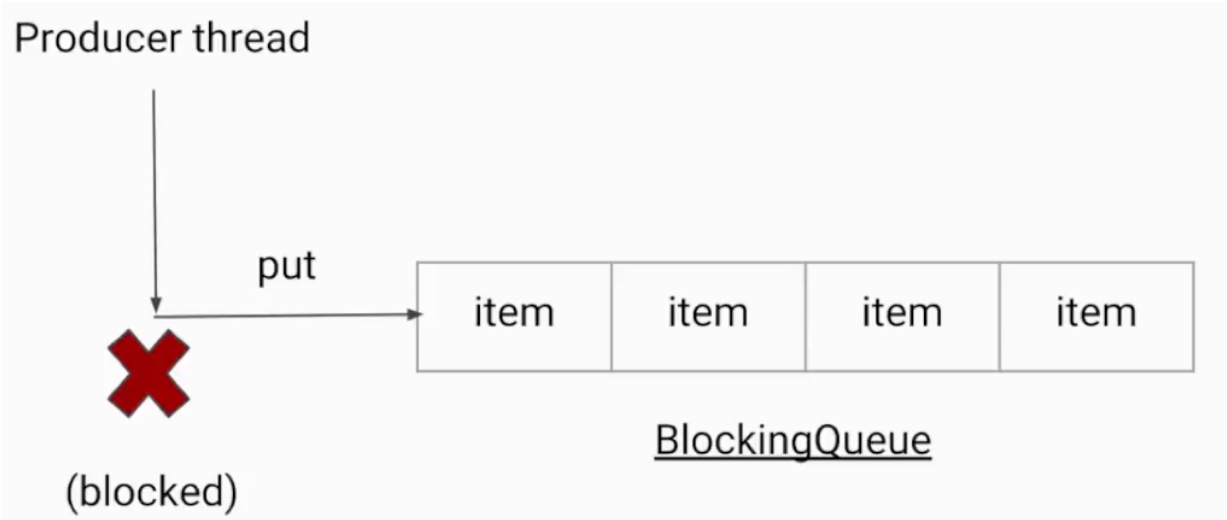

BlockingQueue

阻塞队列是一个具有阻塞功能的队列。

通常,阻塞队列的一端是给生产者放数据用,另一端给消费者拿数据用。阻塞队列是线程安全的,所以生产者和消费者都可以是多线程的。

是否有界(容量多大):这是一个非常重要的属性,无界队列意味着里面可以容纳非常多(Integer.MAX_VALUE,约为 2 的 31 次,是非常大的一个数,可以近似认为是无限容量)

阻塞队列和线程池的关系:阻塞队列是线程池的重要组成部分。

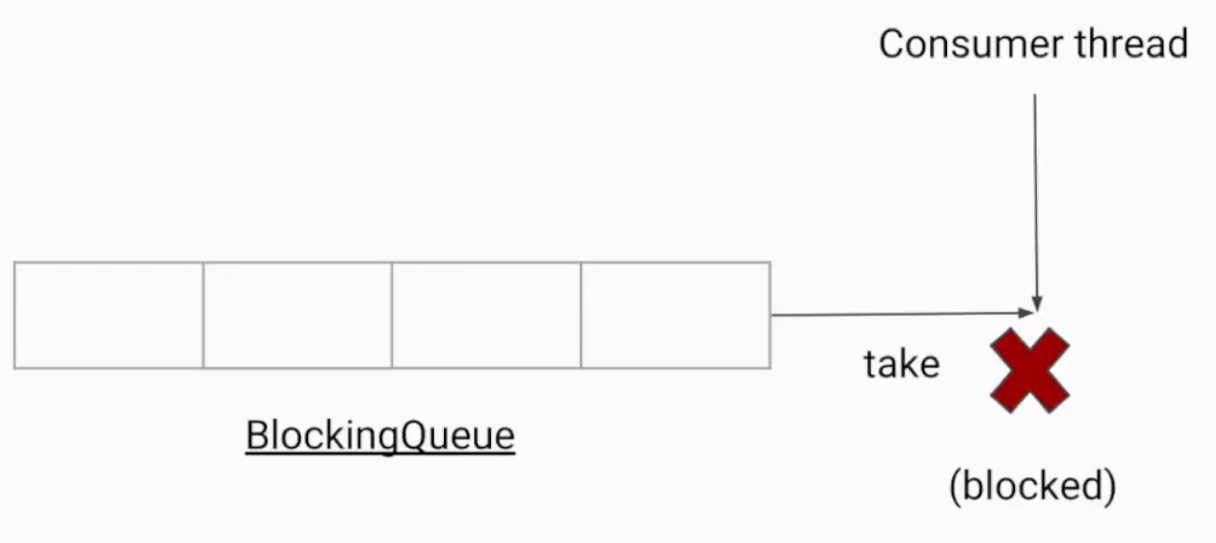

1# 阻塞队列常用方法

2* take() 获取并移除队列头结点,如果执行take()的时候,队列里无数据,则阻塞,直到队列里有数据。

3* put() 插入元素,如果队列已满,则无法继续插入,则阻塞,直到队列里有了空闲空间。

4

5* remove() 删除队列头节点,如果队列中为空,则抛出异常。

6* add() 插入元素,如果队列已满,则抛出异常。

7* element() 返回队列头元素,如果队列中为空,则抛出异常。

8

9* offer 添加,满则返回 false,添加成功返回 true

10* poll 取,如果队列为空,则返回null

11* peek 取出的同时会删除,如果队列为空,则返回null

ArrayBlockingQueue

1* 有界

2* 初始化需要指定容量

3* 公平:公平指的是等待了最长的线程会被优先处理,不过这会地带来一定的性能损耗。

1import java.util.concurrent.ArrayBlockingQueue;

2import java.util.concurrent.BlockingQueue;

3

4/**

5 * 描述: TODO

6 */

7public class ArrayBlockingQueueDemo {

8

9 public static void main(String[] args) {

10

11 ArrayBlockingQueue<String> queue = new ArrayBlockingQueue<String>(3);

12

13 Interviewee r1 = new Interviewee(queue);

14 Interviewer r2 = new Interviewer(queue);

15 new Thread(r1).start();

16 new Thread(r2).start();

17 }

18}

19

20class Interviewee implements Runnable {

21

22 BlockingQueue<String> queue;

23

24 public Interviewee(BlockingQueue queue) {

25 this.queue = queue;

26 }

27

28 @Override

29 public void run() {

30 System.out.println("10个候选人都来啦");

31 for (int i = 0; i < 10; i++) {

32 String candidate = "Candidate" + i;

33 try {

34 queue.put(candidate);

35 System.out.println("安排好了" + candidate);

36 } catch (InterruptedException e) {

37 e.printStackTrace();

38 }

39 }

40 try {

41 queue.put("stop");

42 } catch (InterruptedException e) {

43 e.printStackTrace();

44 }

45 }

46}

47

48class Interviewer implements Runnable {

49

50 BlockingQueue<String> queue;

51

52 public Interviewer(BlockingQueue queue) {

53

54 this.queue = queue;

55 }

56

57 @Override

58 public void run() {

59 try {

60 Thread.sleep(1000);

61 } catch (InterruptedException e) {

62 e.printStackTrace();

63 }

64 String msg;

65 try {

66 while(!(msg = queue.take()).equals("stop")){

67 System.out.println(msg + " 面试结束");

68 }

69 System.out.println("所有候选人都结束了");

70 } catch (InterruptedException e) {

71 e.printStackTrace();

72 }

73 }

74}

110个候选人都来啦

2安排好了Candidate0

3安排好了Candidate1

4安排好了Candidate2

5Candidate0 面试结束

6Candidate1 面试结束

7Candidate2 面试结束

8Candidate3 面试结束

9安排好了Candidate3

10安排好了Candidate4

11安排好了Candidate5

12安排好了Candidate6

13Candidate4 面试结束

14安排好了Candidate7

15Candidate5 面试结束

16安排好了Candidate8

17Candidate6 面试结束

18安排好了Candidate9

19Candidate7 面试结束

20Candidate8 面试结束

21Candidate9 面试结束

22所有候选人都结束了

LinkedBlockingQueue

1* 无界

2* 内部结构:Node、两把锁(读锁、写锁)。分析 put 方法

3* ReentranLock

PriorityBlockingQueue

1* 无界队列(put不会阻塞,take时有可能会阻塞)

2* 支持优先级

3* 自然排序(不是先进先出)

4* PriorityQueue 的线程安全版,采用ReentranLock

SynchronousQueue

1* 队列容量为0,不存储任何元素

2* 直接交换,不做存储,所以效率很高

3* 没有peek()方法

4* 是一个极好的用来直接传递的并发数据结构

5* SynchronousQueue 是线程池 Executors.newCachedThreadPool() 使用的阻塞队列

DelayQueue

1* 延迟队列,根据延迟时间排序

2* 元素需要实现 Delayed 接口,规定排序规则

Non-Blocking Queue

ConcurrentLinkedQueue

并发包中的非阻塞队列只有 ConcurrentLinkedQueue 这一种

1* 链表作为其数据结构

2* 使用 CAS 费阻塞算法来实现线程安全(不具备阻塞功能)

3* 适合用在队性能要求比较高的并发场景,出场频率相对比较少

选择适合的队列

- 边界

- 容量

- 吞吐量(LinkedBlockingQueue 优于 ArrayBlockingQueue)